Datengetriebener zu werden, ist ein Ziel für viele Unternehmen jeder Größe. Wenn es darum geht, die Vorteile zu realisieren , haben die meisten noch viel Arbeit vor sich und viel ungenutztes Potenzial.

Big Data und Analytics haben für viele Unternehmen oberste Priorität. Nur wenige haben bereits Lösungen für maschinelles Lernen und künstliche Intelligenz umfassend integriert. Die meisten müssen noch skalierbare und flexible Datenverarbeitungssysteme einrichten, um die erwartete Menge an Daten und Datenquellen zu bewältigen und so zukünftige Anwendungsfälle zu ermöglichen. Für viele Unternehmen ist Cloud Computing der Eckpfeiler ihres Zielsystems. Heutzutage erfordert der Aufbau einer Datenplattform häufig einen Multi-Cloud-Ansatz, der von proprietären Systemen über Private und Public Clouds bis hin zu mehreren Software-as-a-Service (SaaS)-Produkten reicht.

In diesem Artikel werden einige aktuelle datenbezogene Trends vorgestellt und es wird gezeigt, wie die Cloud helfen kann.

Starke Nachfrage nach Echtzeit-Einblicken

Echtzeit-Einblicke werden immer wichtiger. Unternehmen nutzen zunehmend die Cloud, um ihre Datenplattform aufzubauen, die verschiedene Echtzeit-Anwendungsfälle ermöglicht, beispielsweise in den Bereichen Marketing, Customer Experience und Business Operations. Gemeinsame Bausteine einer Datenplattform, die Live-Einblicke ermöglicht, sind Streaming-Analysen zur Verarbeitung von Daten sowie ein Datenkatalog zur Unterstützung von Self-Service- und Business-Intelligence-Tools für die Visualisierung und Berichterstellung.

Aufbau der Grundlage für maschinelles Lernen und künstliche Intelligenz

Die meisten Unternehmen haben noch einiges zu tun, um Voraussetzungen für Machine Learning & AI Use Cases zu schaffen. Für viele Anwendungsfälle, insbesondere wenn es um vorausschauende Analysen geht, ist der Zugriff auf historische und aktuelle Daten erforderlich. An einem technischen Standort erfordert dies zuverlässige Datenpipelines, skalierbare und dauerhafte Datenspeicherung und skalierbare Rechenleistung, um die erforderliche Verarbeitung durchzuführen. Ein Governance-Modell, das den Zugriff für diejenigen ermöglicht, die ihn benötigen, und gleichzeitig die Einhaltung der Vorschriften sicherstellt, ist ebenfalls erforderlich.

Die Datenmenge wächst

Die Datenmenge in Datenbanken (strukturiert) und Data Lakes (unstrukturierte, semistrukturierte Daten) wächst. Gerade beim Sammeln von Daten von (industriellen) Internet-of-Things-Geräten steigt die Anzahl der Datenpunkte schnell auf ein Niveau, das vor Jahren noch nicht vorstellbar war.

Aber auch Kundendaten, die für Personalisierung und maßgeschneiderte Dienstleistungen oder Produkte genutzt werden, sowie andere Daten steigen.

Heterogene Datenlandschaft

Daten werden in zahlreichen verschiedenen Systemen und Formaten gesammelt und verarbeitet, die eine komplexe Landschaft bilden. Daten finden sich in Legacy-Systemen, die in traditionellen Rechenzentren, Software-as-a-Service-Lösungen, modernen Cloud-Anwendungen und am Edge gehostet werden. Für Anwendungsfälle, die (nahezu) Echtzeitanforderungen haben, ist die Berechnung am Edge oft obligatorisch.

Komplexere Cloud-Setups wie Multi Cloud / Dual Cloud / Hybrid Cloud werden für viele Unternehmen zunehmend Realität.

Daten werden als Produkt behandelt

Einige zukunftsorientierte Unternehmen behandeln Daten als Produkt. Das bedeutet, eine Produktmentalität anzuwenden, die den Kunden in den Mittelpunkt des Handelns stellt. Die Kunden für ein Team, das Datenprodukte bereitstellt, können intern, Partner oder extern sein. Daten können beispielsweise intern oder über APIs (API Economy) oder als Datensätze für das Ökosystem bereitgestellt werden. Kunden entdecken solche Daten typischerweise über API-Verzeichnisse, Datenkataloge und/oder Marktplätze.

Bereiche, in denen die Cloud noch mehr helfen kann

Die großen Cloud-Anbieter haben viele hilfreiche Services in ihren Portfolios, die den Weg Ihres Unternehmens beschleunigen und verbessern können, um datengesteuert zu werden. Es werden nicht nur relevante Bausteine für die Speicherung und Verarbeitung großer Datenmengen bereitgestellt. Laborumgebungen beschleunigen Explorationsaufgaben und Prototyping. Die Cloud-Anbieter bieten moderne, einfach einsetzbare Spezialhardware an, was insbesondere für Machine Learning und Künstliche Intelligenz von Vorteil sein kann. Darüber hinaus bietet das Portfolio der Public Cloud unter anderem ausgefeilte Sicherheitslösungen und das Hosting riesiger öffentlicher oder kommerzieller Datensätze, die innerhalb der Cloud verarbeitet werden können.

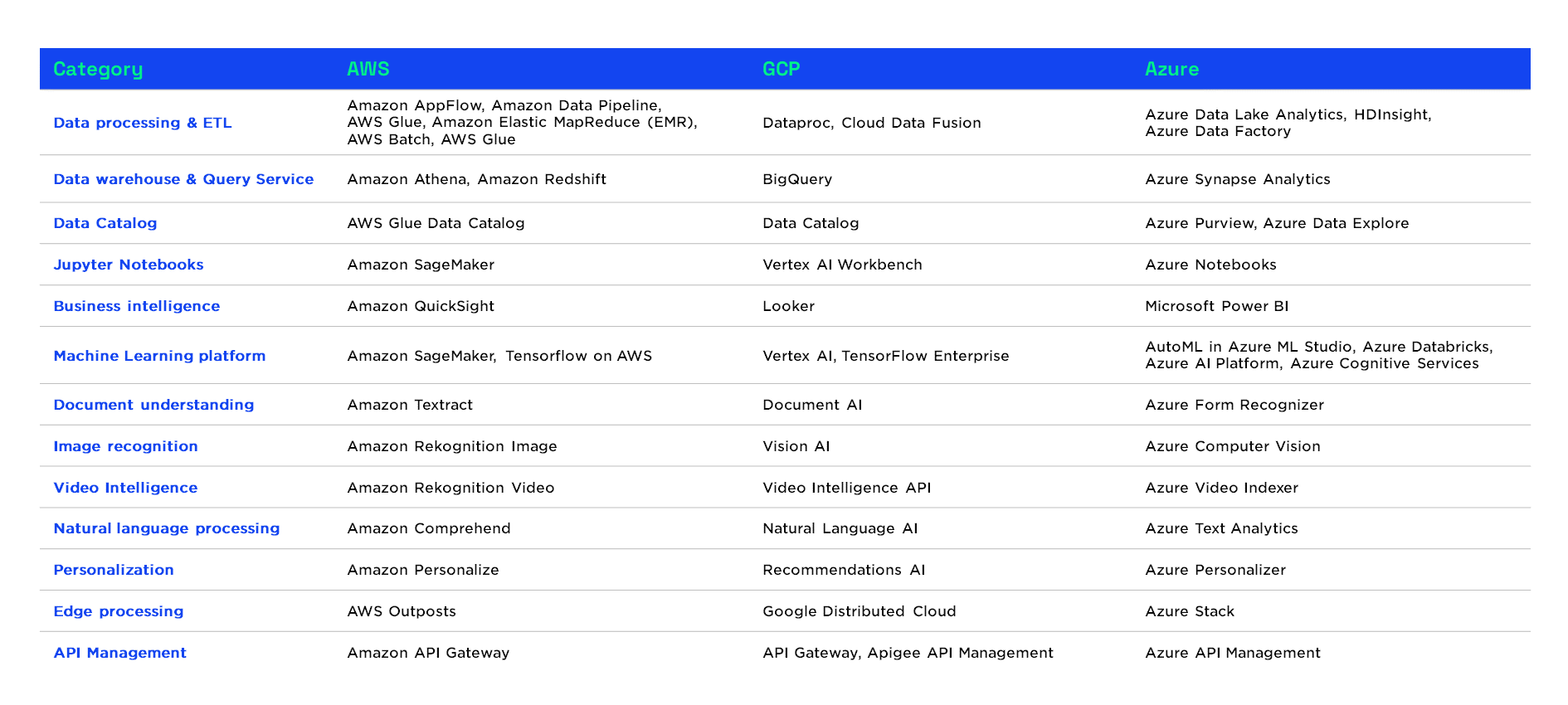

Die folgende Tabelle zeigt eine Auswahl relevanter Services der beliebten Hyperscaler Amazon Web Services (AWS), Google Cloud Platform (GCP) und Microsoft Azure (Azure).

Wenn wir uns die Portfolios der Cloud-Anbieter ansehen, sehen wir, dass die wesentlichen Bausteine, die für die Datenerfassung, -verarbeitung und -analyse erforderlich sind, auf allen Plattformen verfügbar sind. Der Reifegrad der jeweiligen Angebote der Public Cloud Anbieter ist in den letzten Jahren stark gewachsen.

Amazon Webservices ist nach wie vor Marktführer mit dem breitesten und tiefgehendsten Portfolio.

Microsoft Azure war ziemlich spät im Cloud-Spiel, hatte aber einige Jahre Zeit, um aufzuholen und wurde zum am schnellsten wachsenden Anbieter mit einem Portfolio, das Kunden anzieht, die eine lange Geschichte mit Microsoft-Produkten haben.

Die Google Cloud Platform ist sehr stark, wenn es um Kubernetes, Big Data sowie Machine Learning und KI geht.

Dennoch werden für die meisten Anwendungsfälle die Rechenressourcen der Cloud verwendet, in der sich die Daten befinden, da es einen Datengravitationseffekt gibt. Die Übertragung von Daten aus einer Cloud ist mit Kosten verbunden und kostet Zeit, was dazu führt, dass größere Datenmengen typischerweise in der Nähe des Speicherortes verarbeitet werden.

Unsere Cloud-Native-Studie 2022 hat gezeigt, dass schnelle und anpassungsfähige Unternehmen der wichtigste Treiber für den zukünftigen Cloud-nativen Ansatz von Unternehmen sind. Datenbanken, Big Data Analytics und Business Intelligence Lösungen sind die am häufigsten verwendeten Plattformdienste in den befragten Unternehmen. Big Data / Analytics ist der wichtigste bereits implementierte Anwendungsfall und auch der häufigste Cloud-Anwendungsfall, an dem derzeit gearbeitet wird. Unsere Forschung zeigt deutlich, dass sich viele Unternehmen der Cloud zuwenden, wenn es darum geht, die Tools und Plattform(en) zu entwickeln, um datengesteuerter zu werden.

Erfolgsfaktoren & Empfehlungen

Wenn Sie damit beginnen, die Cloud für Ihre datenbezogenen Anwendungsfälle zu nutzen, ist es wichtig, die richtige Balance zu finden: Lassen Sie sich nicht von der Komplexität überfordern, und springen Sie auch nicht ohne Vision ein. Nehmen Sie sich etwas Zeit, um sich über Vision und Strategie klar zu werden, und konzentrieren Sie sich dann auf die Implementierung Ihrer ersten wirkungsvollen Anwendungsfälle. Einige Leitprinzipien niedergeschrieben zu haben, ist ein guter Ausgangspunkt, der durch einen evolutionären Ansatz für Architektur und Vision unterstützt werden sollte. Dies ermöglicht es, schnell zu beginnen, dann spezifischer zu werden und das Gelernte zu integrieren.

Gerade wenn es um Cloud- und Datenarchitekturen geht, sollten wirkungsvolle Entscheidungen – vor allem durch Änderungskosten gekennzeichnet – idealerweise frühzeitig erkannt und gründlich und rechtzeitig getroffen werden.

Nutzen Sie die besonderen Möglichkeiten der Cloud: Die Flexibilität und Skalierbarkeit der Cloud ermöglicht andere Lösungen als in einer On-Premise-Umgebung mit fester Kapazität. Infrastructure as Code ermöglicht die Wiederverwendung von Infrastrukturkomponenten, die schnell erstellt und abgebaut werden können, wenn sie nicht mehr benötigt werden. Plattformdienste bieten gebrauchsfertige Bausteine, die den erforderlichen Aufwand (Setup und Implementierung) drastisch reduzieren können. Dies steht im Gegensatz zum traditionellen Datencenter-Ansatz, bei dem enorme Vorabinvestitionen in die Hardware erforderlich sind und deren Beschaffung und Installationskomplexität und Verzögerungen verursacht.

Unternehmen sollten sich eher früher als später auf die Schaffung von Geschäftswerten konzentrieren. Es wird empfohlen, Anwendungsfälle mit hoher Wirkung direkt anzugehen. Dies ermöglicht es, frühzeitig einen Return on Investment zu erzielen, und stellt sicher, dass das Unternehmen bestmöglich von diesen technologielastigen Aktivitäten profitiert. Die Ausrichtung und Einbeziehung relevanter Parteien – z. B. durch funktionsübergreifende Teams – ist notwendig, wenn die Plattform iterativ aufgebaut wird. Um frühzeitig Werte zu erfassen, empfiehlt es sich, mit vorhandenen Daten zu arbeiten. Verwenden Sie diese Daten, um das, was Sie bereits tun, zu erweitern und zu verbessern. Konzentrieren Sie sich auf Menschen und Prozesse und lassen Sie sich von ihnen zu den richtigen Lösungen führen. Das bedeutet, dass Datenexperten, Cloud-Experten und Business-Experten eng zusammenarbeiten sollten. Außerdem sollten die Endnutzer so früh wie möglich einbezogen werden.

Es geht nicht nur um Technologie – organisatorische Themen wie Fähigkeiten, Talente, Kultur, Betriebsmodell und Prozesse sind sehr wichtig, wenn Sie mit der Technologie Wert schöpfen wollen.

Während Sie fortfahren, behalten Sie das Gesamtbild im Auge. Regelmäßige Überprüfungen und Aktualisierungen Ihrer Gesamtvision und Annahmen können eine große Hilfe sein, um den Zielzustand zu erreichen, der für Ihr Unternehmen ideal ist.