In letzter Zeit sind Gespräche über künstliche Intelligenz (KI) allgegenwärtig. Wenn Sie durch Ihren LinkedIn-Feed scrollen, werden Sie zahlreiche Beiträge über das große Potenzial von KI finden – in allen denkbaren Geschäftsbereichen. Seit dem Aufkommen von ChatGPT wird KI in den Medien und der Politik ausgiebig diskutiert. Selbst bei privaten Treffen wird daraus ein spannendes Smalltalk-Thema. Hoffnungen und Befürchtungen tauchen gleichzeitig auf, genährt von dem Eindruck, dass KI in der Lage ist, fast jede Aufgabe zu lösen, vielleicht sogar effizienter als wir es können. Man könnte den Eindruck gewinnen, dass intelligente Lösungen auf dem besten Weg sind, alle wichtigen Branchen grundlegend umzugestalten.

Wie kommt es dann, dass laut dem IBM Global AI Adoption Index 2022 nur 35% der teilnehmenden Unternehmen angaben, dass sie künstliche Intelligenz einsetzen?

Als Haupthindernisse werden begrenztes KI-Fachwissen, hohe Preise und ein Mangel an Tools und Plattformen zur Entwicklung von KI-Modellen genannt. Neben diesen einschränkenden Ressourcen wurde als weiterer entscheidender Faktor die Vertrauenswürdigkeit genannt. Vier von fünf Unternehmen gaben an, dass es für sie wichtig ist, erklären zu können, wie ihre KI zu Entscheidungen kommt. [IBM Global AI Adoption Index 2022]

Bei Cloudflight bieten wir Zugang zu relevanten Ressourcen und Wissen. Darüber hinaus konzentrieren wir uns auf Erklärbarkeit und Vertrauen, um eine personalisierte Lösung zu entwickeln, die die Akzeptanz der Nutzer sicherstellt.

KI gestalten, die Vertrauen schafft

Der Erfolg oder Misserfolg eines KI-Produkts wird nicht nur durch seine Leistung definiert. Wenn unsere Zielnutzer keinen Nutzen in der Anwendung sehen oder es nicht für vertrauenswürdig halten, steigt das Risiko, dass sie an alten Lösungen festhalten. Dies führt nicht nur zu vergeudeten Entwicklungskosten und -aufwand, sondern kann auch die digitale Transformation Ihres Unternehmens verlangsamen. Glücklicherweise gibt es Ansätze, um diesen Risiken effektiv entgegenzuwirken.

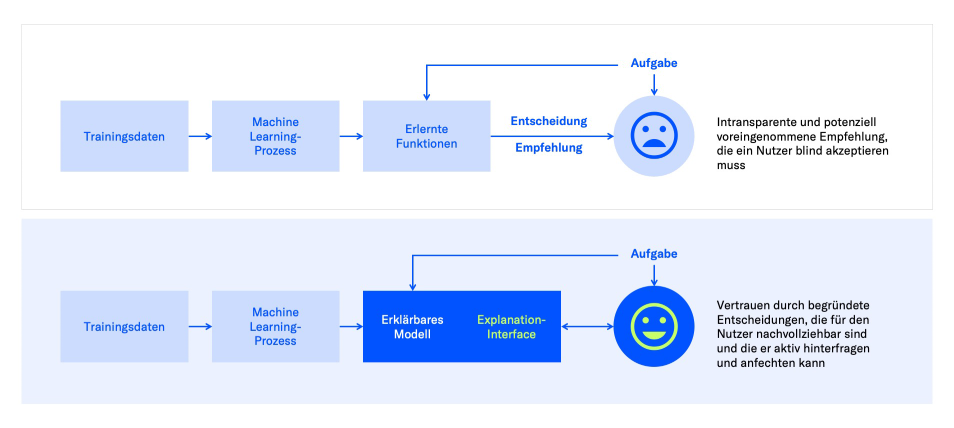

Explainable AI-Ansätze

Eine mögliche Technik ist die Anwendung von erklärbarer KI (XAI). Je nach Komplexität können Machine Learning (ML)-Modelle zu Black Boxes werden. Das heißt, es gibt eine Eingabe und eine Ausgabe. Aber der Prozess, wie das Modell die Eingabe modifiziert, um die Ausgabe zu erreichen, ist schwierig oder unmöglich zu verstehen. XAI zielt darauf ab, klare Erklärungen für die von ML-Modellen getroffenen Entscheidungen oder Vorhersagen zu liefern, die es den Nutzern ermöglichen, die zugrundeliegenden Überlegungen zu verstehen und Muster aufzuzeigen. Dadurch wird deutlich, wie sich unterschiedliche Eingaben auf Variationen in der Ausgabe auswirken. Wenn Sie mehr über die verschiedenen Konzepte erfahren möchten und darüber, wie wir erklärbare KI bei Cloudflight anwenden, sehen Sie hier.

Erklärbare künstliche Intelligenz garantiert Transparenz und Sicherheit

Die Anwendung von XAI ist in vielen Projekten von entscheidender Bedeutung. Je nach Art der Anwendung und dem Kenntnisstand des Nutzers über KI kann die Demonstration der Funktionsweise und Argumentation eines komplexen Modells jedoch zu einer Überinformation führen. Es ist effektiver, die Relevanz darzustellen und das (unerklärte) Ergebnis in einer interpretierbaren und leicht verständlichen Weise zu präsentieren. Darüber hinaus sind State-of-the-Art-Konzepte wie generative Large Language Models (LLMs), wie z.B. ChatGPT, einfach zu groß, um etablierte XAI-Ansätze anzuwenden. In den meisten Fällen, in denen generative Modelle eingesetzt werden, ist es noch wichtiger, die ethische Korrektheit zu garantieren und Aussagen und Behauptungen zu verifizieren.

Verifiziertes Vertrauen: Einhaltung von KI-Vorschriften

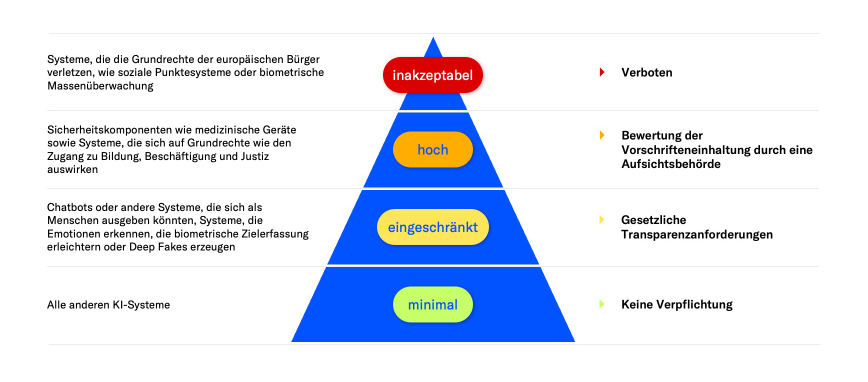

Um die Bedeutung maßgeschneiderter Lösungen für einzelne Anwendungen zu verdeutlichen, werfen wir einen Blick auf die Risikoklassifizierung für KI-Anwendungen gemäß dem von der Europäischen Union vorgeschlagenen KI-Gesetz.

Durch die Gewährleistung des Schutzes der Rechte und Freiheiten des Einzelnen und die Festlegung überprüfbarer Anforderungen an KI-Systeme bietet das KI-Gesetz die Chance, Vertrauen und Akzeptanz für KI-Lösungen in verschiedenen Branchen zu schaffen.

Risikostufen und Auswirkungen des EU-KI-Gesetzes

Inakzeptables Risiko

KI-Systeme, die die Grundrechte verletzen und daher eine Bedrohung für die Bürger der Europäischen Union darstellen, sind verboten. Dazu gehören Systeme, die kognitive Verhaltensmanipulationen – insbesondere bei gefährdeten Bevölkerungsgruppen – vornehmen, Social-Scoring-Anwendungen und viele biometrische Echtzeit- und Fernidentifikationssysteme. Es gibt streng vorgeschriebene Ausnahmen von diesem Verbot im Interesse der nationalen Sicherheit oder der Verfolgung schwerer Straftaten.

Hohes Risiko

In diese Kategorie fallen KI-Anwendungen, die bei unsachgemäßer Handhabung nachteilige Auswirkungen oder Risiken haben können. Beispiele hierfür sind KI-Systeme, die im Gesundheitswesen, bei der Personalbeschaffung, im Bildungswesen oder bei der Strafverfolgung eingesetzt werden. KI-Systeme mit hohem Risiko müssen bestimmte Anforderungen erfüllen, z. B. eine transparente Dokumentation, klare Benutzeranweisungen und menschliche Aufsicht, um Risiken zu minimieren und Sicherheit zu gewährleisten.

So hat es hohe Priorität, dass die Ergebnisse nachvollziehbar sind und die Korrelation zwischen Eingabe und Ausgabe klar ist.

Für Bildklassifizierungsaufgaben können etablierte XAI-Techniken wie das Hervorheben von Bildern mittels Heatmaps in Kombination mit Referenzmustern erfolgreich eingesetzt werden. Für das letztgenannte Beispiel besteht das Ziel darin, Eingangsmerkmale, bei denen es sich höchstwahrscheinlich um demografische und biografische Nutzerdaten handelt, mit der endgültigen Vorhersage in Beziehung zu setzen. Es ist zum Beispiel akzeptabel, dass längere Beschäftigungszeiten zu positiven Empfehlungen führen können. Wir müssen jedoch sicherstellen, dass demografische Aspekte wie Geschlecht, Alter oder Nationalität (und die damit verbundenen sozialen Verzerrungen) die Empfehlungen eines KI-Systems nicht übermäßig beeinflussen.

KI-Systeme mit hohem Risiko werden vor ihrer Markteinführung auf die Einhaltung der Sicherheitsanforderungen hin überprüft und zertifiziert. Auch im Laufe der Lebensdauer des Systems müssen weitere Bewertungen durchgeführt werden. Unternehmen, die diese Systeme auf den Markt bringen, müssen daher auf solide Machine Learning Operations (MLOps)- und Compliance-Verfahren achten.

Begrenztes Risiko

Zu dieser Kategorie gehören KI-Anwendungen, die ein geringeres Schadenspotenzial aufweisen oder deren Risiken besser beherrschbar sind. Diese Systeme haben in der Regel geringere Auswirkungen auf die Rechte und die Sicherheit des Einzelnen. Obwohl es im Vergleich zu den höheren Risikostufen weniger regulatorische Anforderungen gibt, müssen diese KI-Systeme dennoch Transparenz-, Nutzerinformations- und Rückverfolgbarkeitspflichten einhalten.

Vertreter für solche Anwendungen sind Chatbots in verschiedenen Formen, z.B. automatisierter Kundensupport oder Lösungen zur Informationsextraktion, wie z.B. Frage-Antwort-Systeme. Diese Aufgaben werden durch LLMs gelöst, daher sind, wie oben erwähnt, klassische XAI-Methoden nicht anwendbar. Obwohl es Konzepte gibt, um die Aufmerksamkeit der verwendeten Transformer-Modelle zu visualisieren, führt die Verifizierung des generierten Textes in Form von faktengeprüften, nicht-diskriminierenden Aussagen und Antworten zu einer besseren Nutzererfahrung. Ein schrittweiser Verifizierungsprozess kann dies sicherstellen: Klassifizierung oder iteratives Prompting können verwendet werden, um eine nicht-diskriminierende Textausgabe zu gewährleisten, gefolgt von kombinativen Techniken zur Bestätigung von Aussagen und Behauptungen, z. B. mit der Google Search API.

Insbesondere im Hinblick auf LLMs sieht die EU die Verpflichtung vor, das Modell zu registrieren, seine Ausgabe zu kennzeichnen und sicherzustellen, dass die Trainingsdaten zurückverfolgt werden können, um geistige Eigentumsrechte zu schützen.

Minimales Risiko

Diese Kategorie umfasst KI-Systeme, die nur minimale Risiken bergen oder nicht in den Anwendungsbereich der risikoreicheren Anwendungen fallen. Beispiele hierfür sind einfache Tools wie Suchmaschinen oder Spam-Filter. Der regulatorische Aufwand für diese Systeme ist minimal, um Innovationen zu fördern und unnötige Bürokratie zu vermeiden.

Neben der Ausarbeitung von personalisierten Konzepten und deren Entwicklung ist es wichtig, die Nutzer einzubeziehen und regelmäßige Evaluierungsphasen durchzuführen. Auf diese Weise kann sichergestellt werden, dass die ermittelten Konzepte für die jeweiligen Nutzergruppen auch tatsächlich wie erwartet funktionieren.

Erklärbarkeit und Rechtskonformität: Schlüssel zum Erfolg in der KI-Implementierung

Vertrauen ist eine Grundvoraussetzung für die erfolgreiche Einführung von KI-Systemen. Erklärbare KI-Methoden (XAI) können dazu beitragen, die Akzeptanz von KI-gestützten Empfehlungen zu erhöhen. Darüber hinaus legen rechtliche Rahmenbedingungen wie die von der Europäischen Union vorgeschlagene AI Act klare und überprüfbare Anforderungen für den Einsatz von KI-Systemen fest. Die Einhaltung gesetzlicher Vorschriften wird daher immer mehr zu einer Voraussetzung für den Markteintritt. Infolgedessen werden Unternehmen, die XAI-Lösungen sowie robuste Arbeitsabläufe für maschinelles Lernen nutzen, einen erheblichen Wettbewerbsvorteil haben.

Möchten Sie mehr darüber erfahren, wie Sie Ihre KI-Produkte erklärungsbedürftig machen können, oder haben Sie aufgrund der Benutzerakzeptanz Bedenken, mit KI zu beginnen? Sprechen Sie uns an, unsere Experten freuen sich darauf, eine maßgeschneiderte Lösung für Ihr Unternehmen zu entwickeln!