- Rancher, der Anbieter von Kubernetes-Management-Lösungen, hat seine neue Kubernetes Distribution K3s angekündigt

- K3s ist eine Lightweight-Variante von Kubernetes, die trotz zahlreicher Abspeckmaßnahmen der Standard Kubernetes Variante alle Vorteile des Container-Betriebs mitbringt

- Insbesondere für IoT-Architekturen, Edge Computing oder ARM-basierte Server soll K3s funktionieren und eröffnet somit völlig neue Möglichkeiten im Business-Einsatz

Cloud-native Technologien sind schneller als gedacht zu einer unverzichtbaren Komponente der Unternehmen und CIO-Agenden geworden. In allen Unternehmensbereichen geht es mittlerweile darum, schnell, agil und flexibel neue digitale Lösungen und Software startklar zu machen, um digitale und datengetriebene Geschäftsprozesse Realität werden zu lassen.

Gerade für den Betrieb und die agile Entwicklung der Anwendungen hat sich dank “cloud-native” in den vergangenen Monaten einiges getan. Die Container-Technologie, die vor zwei Jahren noch ein Nerd- und Nischenphänomen war, drängt derzeit so stark in die Unternehmen, wie es wohl kaum jemand für möglich gehalten hätte. Der Betrieb neuer und bestehender Anwendungen auf ein oder mehreren hybriden Cloud-Architekturen soll bald selbstverständlich sein, um in Sachen Performance, Erreichbarkeit, Flexibilität und auch Qualität der Anwendungen keinerlei Abstriche mehr machen zu müssen. Ähnlich wie bei virtuellen Maschinen können Container elastische Infrastrukturen erzeugen. Allerdings deutlich leichtgewichtiger und vor allem Betriebssystem-übergreifend. Denn VMs abstrahieren die Hardware, Container das Betriebssystem. So beschleunigen Container Services die Bereitstellung neuer Funktionen, verbessern die Widerstandsfähigkeit einer Infrastruktur und verlagern einen Großteil der manuellen und aufwändigen Arbeit beim Aufbau, dem Betrieb und der Wartung von Produktionsumgebungen vom Menschen auf Software.

Nicht zuletzt dank Kubernetes als Open Source-Standard für die Container-Orchestrierung, wurde den Unternehmen schnell eine neue Welt eröffnet, die echte Hybrid und Multi Cloud Operations auf Basis von Containern wirklich Realität werden lässt. Wie bereits in unseren Kubernetes & Cloud-native Trends 2019 beschrieben, wird gerade das Jahr 2019 besonders wichtig sein. Viele Unternehmen stehen unmittelbar davor, ihre Kubernetes- und Container-Umgebungen vom Development- & Test-Stadium in ein Produktivstadium zu überführen.

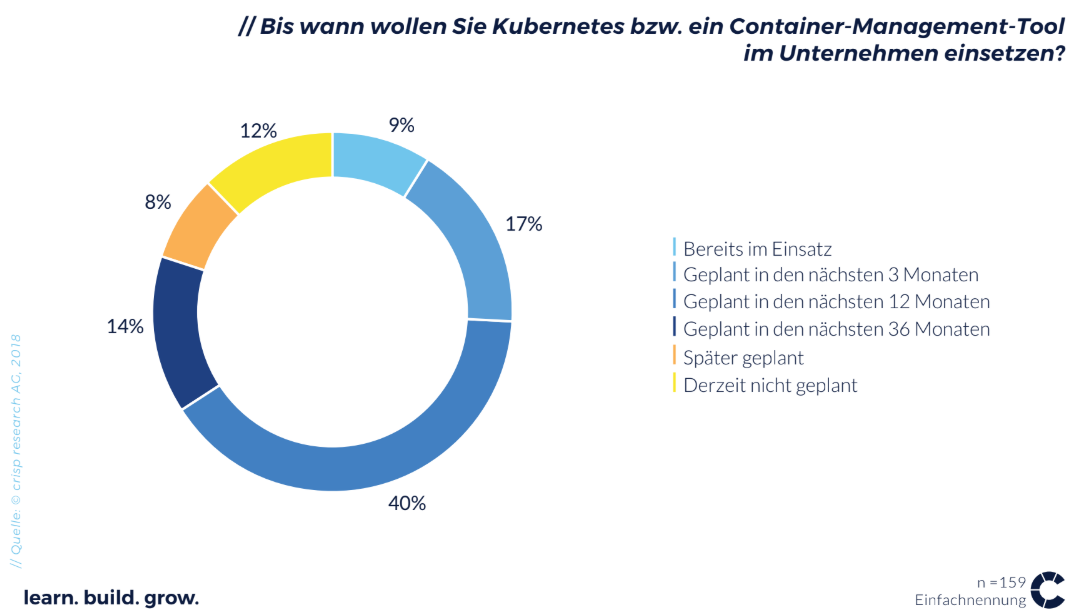

Nach einer Studie von Crisp Research im Jahr 2018 ist der Einsatz von Container-Management-Tools wie Kubernetes für 80 Prozent der Unternehmen bis zum Jahr 2021 gesetzt. Dabei helfen vor allem die zahlreichen Betriebsmodelle und Optionen, die Unternehmen für den Container Betrieb erhalten. Insbesondere im Produktivstadium setzen viele Unternehmen auf hybride oder on-premises Optionen, was auch dank der Announcements von Google mit GKE on-prem immer stärker erleichtert wird.

K3s – Vollwertiges Kubernetes ohne Extras (, die man gar nicht immer braucht)

Die Innovationsgeschwindigkeit um Kubernetes ist enorm! Dank der zahlreichen Kontributoren, Dienstleister und Mitglieder insbesondere in der Cloud-native Computing Foundation kommen immer wieder neue Flavours und Modelle auf den Markt, die neue Workloads einfacher betreiben lassen oder White Spots in der bisherigen Umsetzung gerade für die Enterprise-IT überwinden sollen.

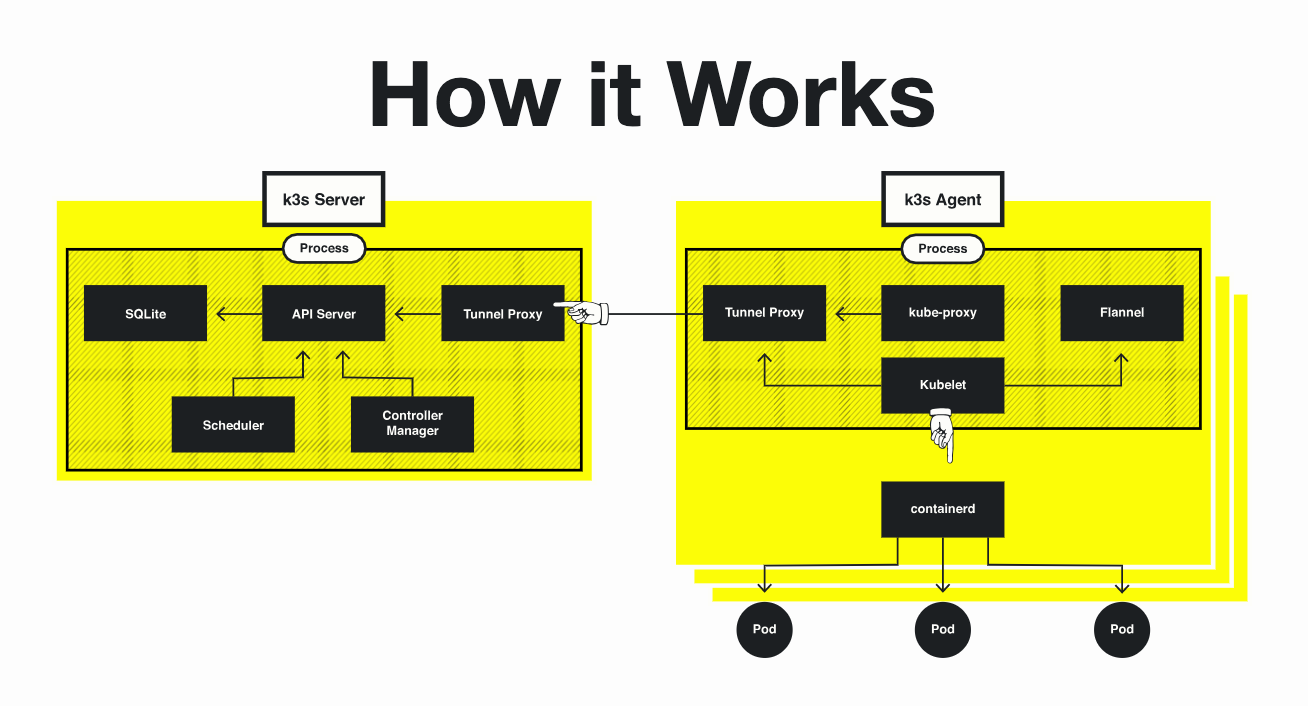

Die neueste Entwicklung, hervorgebracht von dem Kubernetes- und Container-Management-Spezialisten Rancher, ist die K3s-Distribution. K3s ist im Wesentlichen eine Lightweight-Variante von Kubernetes, die sich auf wichtige Basis-Features beschränkt und Anpassungen an der Architektur macht, um mit wenig Arbeitsspeicher und Compute-Power vollwertige Container-Plattformen zu betreiben.

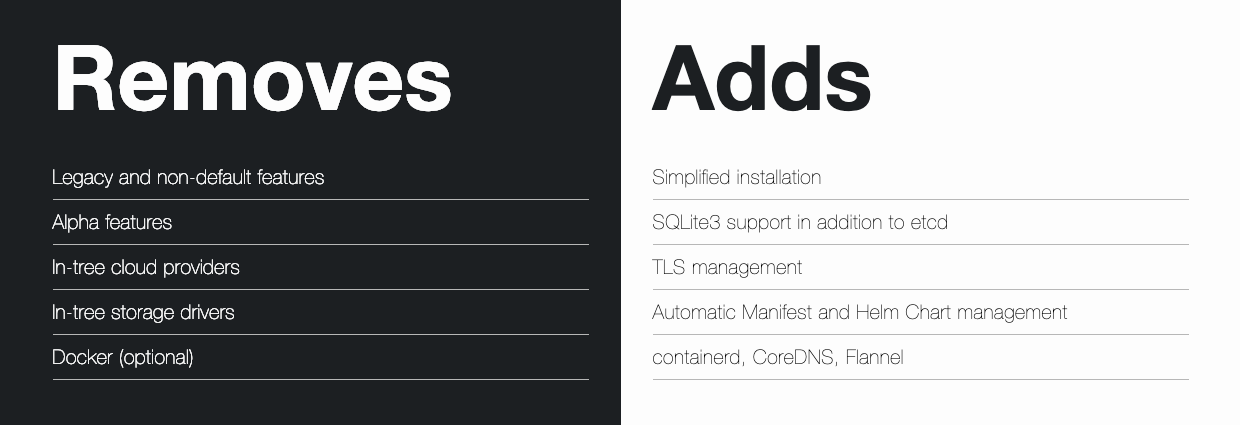

Mit angepassten Datenbank-Services und einigen fehlenden “non-default features” schafft es K3s als Binary nur eine Größe von 40 MB zu besitzen. Damit kommt K3s mit nur 512 Megabyte Arbeitsspeicher pro Server und 75 Megabyte pro Node aus. Mit 200 MB Speicherbedarf auf der Festplatte ist die Distribution damit ideal für kleinere Servertypen wie insbesondere ARM-Server (ARMv7, ARM64) geeignet.

Dennoch ist es ohne weiteres möglich echte Produktivworkloads wie auf den klassischen Distributionen zu betreiben. Die Installation ist nochmal vereinfacht, sodass auch die Time-To-Market noch einmal verkürzt wird. Das TLS-Management hilft http oder MQTT Protokolle abzusichern.

Kubernetes meets IoT – K3s für Container-Computing at the edge

Kubernetes und Container-Technologien sind definitiv ein Gamechanger im plattformunabhängigen Anwendungsbetrieb und der Entwicklung. Derzeit werden sie insbesondere dort auch am meisten genutzt, um Vorteile in Sachen Geschwindigkeit, Elastizität und unter dem Strich auch für geringere TCO zu nutzen.

Andere Workloads, die unmittelbar darauf aufbauen, wie beispielsweise IoT-Architekturen, profitieren ebenfalls von Kubernetes und Container Services. Allerdings ist gerade das Thema Edge Computing für IoT-Architekturen ein wesentliches Thema, wo klassische Modelle derzeit noch ihre Schwächen haben. Mit K3s können auch auf kleineren Serverumgebungen ausreichend große Container-Cluster betrieben werden.

Beispielsweise können Windparks zukünftig als Micro-Datacenter für IoT-Architekturen auf Container-Basis dienen. Der Raum, den Windkraftanlagen schon heute bieten (ca. 20 qm im Sockel der Anlagen), wird bereits für große Serverarchitekturen genutzt. Ein Micro-Datacenter, bspw. auf Basis von ARM-Servern und K3s als Container-Umgebung könnte direkt die Steuerung, Auswertung und den Betrieb der IoT-Architekturen im Windpark übernehmen. Der Vorteil von K3s ist, dass zukünftig auch die Steuergeräte im Schaltschrank der Anlagen mit der gleichen Software für das Management ausgestattet werden können, wie die großen Server. Im Verbund können die kleinen Micro-Datacenter sogar größere Workloads betreiben und haben so einen erheblichen Vorteil für einen variablen Einsatz. Der Vorteil dieser Architektur an der Edge ist auch, dass auch dort der Zugang zu Strom und ausreichend Energie in jedem Falle gewährleistet ist – relativ umweltfreundlich und dank kurzer Übertragungswege sehr effizient. Dank teuto.net gibt es bereits erste Beispiele auch in Deutschland, wo die Beta-Versionen von K3s genutzt werden.

K3s – ein weiteres Puzzleteil im cloud-native Siegeszug

Dass K3s in der Praxis genauso zuverlässig und leistungsstark funktionieren kann, wie eine vollwertige Kubernetes-Distribution, muss sich noch beweisen. Allerdings kann K3s gerade für Edge-Szenarien neue Wege eröffnen und auch darüber hinaus die Container Operations auf kleineren Serverfarmen deutlich verbessern. Die Reaktion der Community ist bislang mehr als positiv.

Gerade im Kontext IoT und Edge Computing entstehen hier neue Möglichkeiten. Denn das bislang unterschiedliche Management zwischen Cloud und Non-Constraint-Controllern wird überflüssig. Dank K3s kann die exakt gleiche Business Logik genutzt werden, unabhängig ob ein Sensor über ein Gateway oder direkt mit der Cloud kommuniziert. Die Business-Logik aus der Cloud kann eben mit K3S auf das Gateway deployed werden.

Insbesondere wenn Unternehmen derzeit ihre cloud-native- und Container-Strategien planen und umsetzen oder im IoT-Umfeld konkrete Projekte planen, sollten sie in jedem Fall ein Auge auf K3s und mögliche Alternativen werfen.