- Gaia-X ist ein vom Bundesministerium für Wirtschaft initiiertes Konzept, das eine Deutsche Datensouveränität sicherstellen will.

- Das Wirtschaftsministerium verfolgt eigentlich ein gutes Ziel, das endlich das Teilen von Daten und damit den Erfolg von künstlicher Intelligenz in Deutschland stimulieren könnte.

- Leider scheint das Ministerium weder aus den bisher gescheiterten Nationalen Cloud Initiativen gelernt zu haben, noch die globalen Skalen- und Wettbewerbseffekte der Branche für sich zu nutzen.

Eigentlich hört sich die Idee einer nationalen Datensouveränität erst einmal gut an. Als überzeugter Europäer fragt man sich natürlich, warum hier das Deutsche Bundesministerium für Wirtschaft und Energie (BMWi) als großer Initiator der Gaia-X Initiative erscheint und nicht gleich die Europäische Union. Setzt sich eine Daten-Souveränität doch hauptsächlich aus den drei Komponenten

- Lokalität der Daten,

- Rechtsraum in dem die betreibenden Firmen agieren,

- Nationalität und Compliance der Personen die mit dem Betrieb von Rechenzentrums- und Plattform-Diensten betraut sind,

zusammen. Alle drei sind bereits mittelfristig über die EU homogen. Aber die EU ist sich außenpolitisch nicht einig. Während Frankreichs Präsident Macron auf den fairen Wettbewerb baut und die Amerikanischen Konzerne deshalb dazu zwingen möchte, auch Steuern im Land der Leistungserbringung zu zahlen bzw. im entsprechenden Maße Import-Zoll zu zahlen, hat sich in Deutschland kein Regierungspolitiker wirklich getraut diese “Internet-Steuer” gegen Amazon, Google und Microsoft’s Cloud-Dienste zu erheben. Zu groß war die Angst vor noch mehr Repressalien unserer Auto-Industrie durch die Trump Administration. Dementsprechend kommt das Gaia-X Konzept jetzt mit einer Mischung aus Nationalismus und Stimulation der verbleibenden “kleinen” IT-Dienstleister. Alle Hyperscaler (AWS, Azure, Google) und sogar IBM sind bisher nicht involviert, werden sogar als Konkurrenz gesehen. Anstelle dessen redet Altmaiers Team mit den “Deutschen” Unternehmen SAP, Deutsche Telekom und Deutscher Bank, sowie einigen wirklich kleinen IT-Dienstleistern, die im Vergleich zu den amerikanischen Gorillas kaum noch eine Rolle spielen. Was am Markt ankommt ist eine Deutsche Cloud gegen die großen Amerikaner!

Dabei müssten es die genannten drei deutschen Player dem Wirtschaftsministerium eigentlich erklären können. SAP hat zum Beispiel mit der Hana Plattform einen der stärksten Software Stacks der Welt für Unternehmensanwendungen. Doch als End-2-End Cloud-Provider rudert SAP nach anfänglicher Euphorie der SAP Hana Cloud inzwischen wieder mächtig zurück. Selbst SAP’s Infrastruktur ist für das Volumengeschäft zu klein und die Margen deutlich geringer als bei der Business Software selbst. Denn der erste Service Level Infrastructure-as-a-Service (IaaS) ist ein richtiges Massengeschäft. Hier präferiert SAP für die meisten Kunden inzwischen den Betrieb seines Hana-Stacks auf Infrastruktur eines der hyper-wachsenden amerikanischen Provider (AWS, Azure, Google). Das verbleibende eigene Infrastruktur-Business von SAP droht immer mehr in eine teure Nische für eine sehr kleine Klientel abzurutschen.

Die Deutsche Telekom hat eigentlich auch genügend Erfahrungen mit ihren Cloud-Angeboten gemacht, um das BMWi zu warnen. Früh hat der ehemalige Telco-Monopolist erkannt, dass neben dem reinen IaaS Angebot besonders die modernen Platform-as-a-Service Dienste für Entwickler attraktiv sind. Das ist aber ein Software-Innovations-Business, kein Netz und Infrastruktur-Business. Die Deutsche Telekom hatte deshalb mit Microsoft eine lokale Azure-Zone unter ihrer Treuhänderschaft aufgebaut: Personen, Rechtsraum und natürlich die Datenhaltung in Deutschland im Telekom-Rechenzentrum. Nur der Technologie-Stack kam von Microsoft’s Azure. Kein Microsoft-Mitarbeiter hatte physisch Zugriff zum Rechenzentrum. Das ganze Projekt ist 2018 mit Pauken und Trompeten gegen die Wand gefahren! Nur wenige Kunden wollten einen 10-15% Aufpreis für die Deutsche Datensouveränität zahlen. Die letzten Kunden mussten ihre Anwendungen auf eigene Kosten in eine der großen Clouds umziehen. Wahrscheinlich hatte aufgrund dieser Erfahrungen nur Sabine Bendiek, Geschäftsführerin von Microsoft Deutschland, den Mut sich deutlich kritisch zu Gaia-X zu äußern. AWS und Google halten sich politisch korrekt zurück, da sie sich üblicherweise zurückhaltend zu “Nationalen Clouds” verhalten. Sie wissen, dass eine Cloud ohne sie und Microsoft nie die Skaleneffekte und damit die finanzielle Konkurrenzfähigkeit erreichen wird, die der Markt verlangt. Alle großen Amerikaner sind inzwischen so weitreichend DSGVO-kompatibel, dass selbst einige mittlere Finanzdienstleister aus Deutschland zu ihren Nutzern zählen. Heute vertreibt die Deutsche Telekom die Azure Plattform aus dem Microsoft Rechenzentrum – nicht aus dem eigenen.

Auch eine Deutsche Bank könnte Herrn Altmaier ein wenig mehr über den Charakter ihrer IT-Workloads erzählen. Immer wenn die Leistungsanforderungen stark fluktuieren, wie bei einem Retailer vor Weihnachten oder wenn viele verschiedene Firmen entlang einer Industrie 4.0 Supply-Chain miteinander kollaborieren wollen, wie bei Volkswagen, punkten die Public Clouds. Diese Fälle sind bei einer Bank oder Börse aber eher selten. Deshalb betreiben die Größen der Finanzbranche ihre Kern-Infrastruktur selbst! Wenn man die Elastizität der Infrastruktur nicht braucht, wenig fully-managed Plattform-Dienste (PaaS) einsetzt und selbst an einem Ort bestimmte Skaleneffekte erreicht, ist eine Public Cloud nicht mehr günstiger. Man teilt sich gerne Strom, Netzwerk und Kälte mit den Amerikanischen Cloud-Providern und mietet Rechenzentrum-Fläche bei den Frankfurter Colocation-Anbietern. Das ist aber auch schon alles. In Summe schätzt Crisp Research die Mehrzahl der heute an Gaia-X beteiligten Großunternehmen NICHT so ein, dass sie ihre Core-Workloads oder Revenue-Streams mit Gaia-X in Einklang bringen könnten.

Dabei sind im vollständigen Konzept von Gaia-X schon eine Menge gute Ideen drin. Es geht gar nicht nur darum, ob die Infrastruktur von einem der vier Amerikaner kommt. Der ursprüngliche Anspruch war ja jedes Monopol zu vermeiden und vor allem ein Ökosystem zu stimulieren, in dem der Austausch von Daten (z.B. der Zugriff auf Lernmodelle) konform mit unserer Rechtsauffassung ablaufen kann.

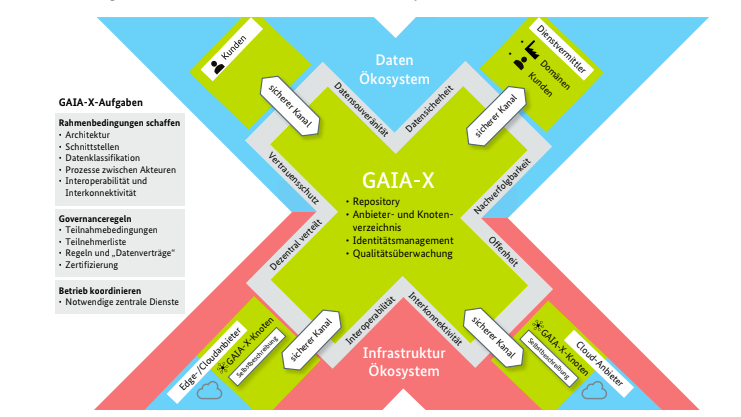

Gesamtbild Dateninfrastruktur und Ökosystem, Quelle BMWi

Die offizielle Abbildung zeigt wie das Daten-Ökosystem auf einem verteilten Infrastruktur-Ökosystem aufbauen soll. Eine Data-Economy aufzubauen, die keinen Lock-in zu einer bestimmten Infrastruktur hat, ist klasse! Ein Stück weit gibt das Gaia-X Infrastruktur-Ökosystem genau das wieder, was jeder der drei Hyperscaler technisch jetzt schon mit seinen Availability Zones – eben proprietär – implementiert hat. Crisp Research könnte sich vorstellen, dass das Gaia-X Knotenverzeichnis ein Meta-Repository über Kubernetes-Cluster ist. Aber so konkret ist das Projekt noch lange nicht. Das Konzept schlägt für die Schaffung eines offenen Standards und einer Referenzarchitektur die Etablierung einer Europäischen Organisation vor:

“Zur Umsetzung der vernetzten Dateninfrastruktur erachten wir eine zentrale, europäisch getragene Organisation für notwendig. Sie soll aus wirtschaftlicher, organisatorischer und technischer Sicht die Basis für eine vernetzte Dateninfrastruktur sein. Ihre Aufgabe wird sein, eine Referenzarchitektur zu entwickeln, Standards zu definieren sowie Kriterien für Zertifizierungen und Gütesiegel vorzugeben. Sie soll ein neutraler Mittler und Kern des europäischen Ökosystems sein.” (Das Projekt GAIA-X, BMWi)

Die International Data Spaces (IDS)-Initiative, die sehr stark vom Fraunhofer Institut stimuliert wurde, wird als erfolgreiches Beispiel angeführt. Jedoch haben in Sachen vernetzte Dateninfrastruktur die “vier Amerikaner” einfach die größte Kompetenz am Markt. Es wäre gut diese Kompetenz zu nutzen ohne Abhängigkeiten und Monopole einzugehen.

Ein Punkt der vollkommen fehlt, sind die Hybriden und Multi-Cloud Szenarien. Und dabei geht es um ganze konkrete Szenarien, die wir im Markt sehen. Hier ein Beispiel: Heute – 20 Jahr nach der Storage-Konsolidierung in Enterprise-Rechenzentren – versteht jeder CIO was kalte (alte) und heiße (aktuelle) Daten sind – und speichert sie entsprechend auf unterschiedlichen Systemen, um Preis und Zugriffszeiten zu balancieren. In gleicher Weise teilen Unternehmen in der Zukunft ihre Daten auf modernen Microservice-Architekturen erneut in zwei Teile. Möglichst wenige, aber sehr sensible Daten, werden vollständig verschlüsselt und ggf. in maximaler (Deutscher) Daten-Souveränität abgelegt. Das macht beispielsweise Bosch im Moment in eigenen Rechenzentren, die zwar deutlich teurere als AWS/Azure/Google sind, aber die eigene Souveränität liefern. Der volumenmäßig viel größere Teil läßt sich aber meist so weit anonymisieren und “tokenizen”, dass er problemlos am günstigsten Ort liegen kann. Im Beispiel des Autonomen Fahrens sollten die Telematik-Daten, die zeigen, dass einige Autos vor einer Schule scharf bremsen mussten, am besten UN-verschlüsselt an der günstigsten Stelle liegen und für Maschinelles Lernen zugänglich sein. Das ist genau der Inhalt, der schon lange überfälligen Kooperationen der Automotive OEM zum autonomen Fahren. Welche Fahrzeuge oder Fahrer jedoch tatsächlich scharf bremsen mussten, ist natürlich sehr vertraulich und liegt tatsächlich besser in einer Bosch Cloud.

Ganz ähnlich sollte es sich mit der elektronischen Gesundheitsakte verhalten. Der Patienten-Namen, Versicherungsnummer und ein geheimer Schlüssel (Token) sollte an sehr sensiblen Orten liegen. Dazu könnte Gaia-X den (zertifizierten) Souveränitäts-Level eines Infrastruktur-Knotens einführen. Faktisch wären das auch nur ein paar Gigabyte für alle Versicherten Deutschlands. Ein gescanntes Röntgenbild hingegen, sollte so anonymisiert und fragmentiert sein, dass man nicht auf den Patient zurückschließen kann. Damit sind diese Daten eigentlich ohne den Zugang zu den Tokens nicht mehr personenbezogen und könnten auf einem Gaia-X Knoten mit niedrigstem Souveränitäts-Level gespeichert sein. Das sollte dann eigentlich sogar ein amerikanischer Hyperscaler sein, denn der würde den Preispunkt für Petabytes an Röntgenbildern nach unten bringen. Multi-Cloud ist also kein Buzzword, sondern konkret der wichtigste Lösungsansatz um Privatsphäre und Kosten durch das Orchestrieren mehrere Dienste zu balancieren – genauso wie es die CIOs früher mit Zugriffszeiten und Kosten ihrer Storage-Systeme gemacht hat. Leider steht nichts davon im Gaia-X Konzept!

Das BMWi hat im Vorfeld der Ankündigung viel zu wenig mit den Branchen-Insidern gesprochen. Selbst der Branchenverband Bitkom war eher Zuschauer als Knowledge-Pool für das Berliner Ministerium. Um die öffentliche Diskussion um die Datensouveränität etwas zu strukturieren, schlägt Crisp Research zum Beispiel eine Betrachtung entlang des bekannten Cloud-Service-Stacks vor. Dann wird klar wo man überhaupt Datensouveränität braucht:

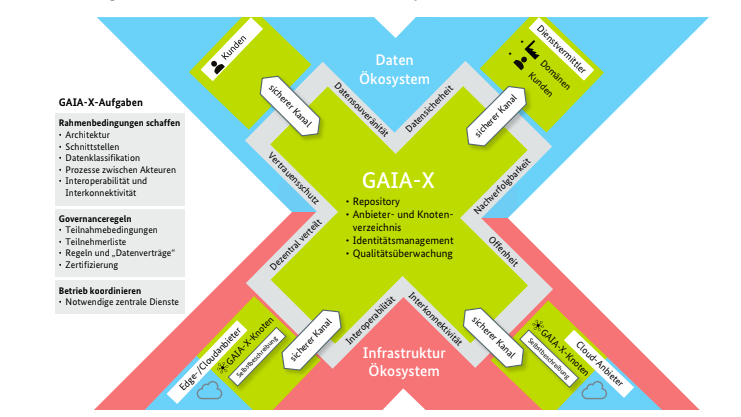

Quelle: Crisp Research

- Colocation – wem die Rechenzentrumsfläche gehört, ist unbedeutend. Heute sollten eigentlich alle Rechenzentren, egal ob von einer einzelnen Bank, einem Deutschen Service Provider oder von einem Hyperscaler, auf oder direkt neben dem Campus eines Colocator-Anbieters liegen. Stark vereinfacht bietet dieser ja einfach eine Raummiete mit gemeinsamer Strom-, Kälte- und Netzversorgung. Hier ist die beste Energieeffizienz, Ausfallsicherheit und Konnektivität. Nur Edge-Computing Situationen, die viele Daten lokal an einer Industrieanlage oder autonomes Handeln eines IoT Devices erfordern, bilden hier eine Ausnahme. Keinem “Colo” gehören irgendwelche Server. Die Colos sind inzwischen im Großraum Frankfurt ein signifikanten Wirtschaftszweig, für die eigentliche Daten-Souveränität aber irrelevant.

- IaaS – sollte Kosten mit Nationaler Souveränität balancieren. Stellen Sie sich vor, Sie sind IaaS-Provider und plötzlich steht die Deutsche Polizei oder der NSA/CIA/FBI mit einem Hausdurchsuchungsbeschluss vor der Tür. Dann ist natürlich der Rechtsraum ihrer Gesellschaft entscheidend. Die deutschen Unternehmen werden die amerikanischen Agencies eher nicht rein lassen. Genauso wichtig ist aber, was die Polizei oder Agency dort überhaupt finden würde. Im obigen Multi-Cloud Beispiel des anonymisierten Röntgenbildes hätte der NSA keine Chance an personenbezogene Dinge zu kommen, wenn ihm nicht gleichzeitig die Deutsche Polizei den Personen-Schlüssel aus der Durchsuchung des “deutschen” Gaia-X Knotens ausgehändigt hat. Zudem speichert ein erfahrener Cloud-Entwickler sensible Daten in einer Cloud immer verschlüsselt. Die Deutsche Polizei müssen also auch noch das verdächtigte Unternehmen selbst durchsuchen um ggf. lokal gespeicherte Client-Zertifikate zu erhalten.

- PaaS – Sollte für Gaia-X eigentlich viel Interessanter als IaaS sein. Hier kann man sich eine Menge schlauer PaaS-Dienste vorstellen die Gaia-X als Zielplattform interessant machen. Die Bundesregierung hat auch interessanter Assets, wie die Identität der Bürger aus dem elektronischen Personalausweis. Würde Gaia-X eine einzige PaaS-API für das Speichern eines sensiblen Media-Files anbieten, wäre die Logik ein Röntgenbild zu anonymisieren, die sensiblen Metadaten an einen Gaia-X Knoten und die unsensiblen Bilddaten an einen anderen zu speichern, nur noch ein paar Zeilen Code. Solche branchenunabhängigen Plattform-Dienste würden Gaia-X zum Durchbruch verhelfen. Sie würden aber auch ein Entwicklungsbudget erfordern, dass heute keiner alleine einbringt.

- SaaS ist der kritischste Dienst für die Datensouveränität. SaaS liefert ja fertige Business-Anwendungen oder Geschäftsprozesse, die in gleicher weise von vielen Unternehmen genutzt werden. Die Daten sind dem Provider im allgemeinen unverschlüsselt zugänglich. Deshalb können Amerikanische Agencies die eMails oder Office Dokumente aus Microsoft’s Office 386 anfordern, genauso wie ein Deutsches Gericht, SAP anweisen kann Transaktionen aus S4 auf der Hana Cloud heraus zu geben. Die Provider müssen sich gegen solche Anfragen immer wieder im Einzelfall gerichtlich wehren. Leider betrachtet das Gaia-X Konzept den SaaS-Level überhaupt nicht. Zwar bringen sich aber deutsche SaaS Anbieter wie die Firma Open-Xchange als Alternative zu Office 365 aktiv ein, aber der Punkt muss strategischer Fokus werden.

Das Gaia-X Konzept hat also noch eine Chance, wenn die Macher aus den Fehlern der erfolglosen Nationalen Clouds lernen, ihren Wertbeitrag auf alle drei Ebenen des As-A-Service Stacks anwenden und in einen Infrastruktur-unabhängigen PaaS Stack investieren. Letzterer muss Multi-Cloud Szenarien der zukünftigen Data-Economy unterstützen. Damit hätten Kunden eine Lösung die sowohl die Anforderung der Deutschen Souveränität erfüllt, als auch die Konkurrenzfähigkeit der amerikanischen Hyperscaler für das große Volumen nutzt. Den Hyperscalern würde es Traffic bringen solange es die politische Lage erlaubt, aber für die Kunden im Idealfall keinen Lock-In. Vor allem IBM, gefolgt von Microsoft, haben formal Interesse für eine Beteiligung an Gaia-X beim BMWi bekundet, wie die beiden Firmen auf Anfrage der Crisp Research bestätigten.

Mit den “Vier Amerikanern” und vielleicht sogar den Chinesen (Alicloud) wird was aus Gaia-X – ohne oder gar gegen 90% des Cloud-Marktes wird’s eher ein peinlicher Mega-Flop.