Menschen, die in Bereichen arbeiten und wirken, die nah an neuen technologischen Innovationen und Lösungen angesiedelt sind, sind es bereits gewohnt, mit Veränderung umzugehen und haben gelernt schnell darauf zu reagieren. Die Welt von Kubernetes und den Cloud-Native-Technologien ist ein Paradebeispiel für einen Bereich mit einer hohen Dynamik. Doch in der aktuellen Lage rund um die Corona-Pandemie scheinen die alltäglichen Herausforderungen neuer Technologien direkt wieder in den Hintergrund zu rücken. Denn es geht darum, erst einmal die Basics für den Fortbestand des Unternehmens und seiner digitalen Infrastruktur zu sichern.

Dort sind Cloud-Native-Technologien vielerorts gesetzt und leisten potenziell ihren Teil für eine schnelle, ausfallsichere und flexible IT. Darüber hinaus gibt es auch eine Zeit nach dem großen Chaos, die möglicherweise nach der ersten Schockwelle erreicht wird.

Wie geht es dann mit den Innovationen der IT und Digitalisierung weiter? Sind sie überhaupt durch Corona und Co. “on hold” oder kommt gerade jetzt ihre Zeit?

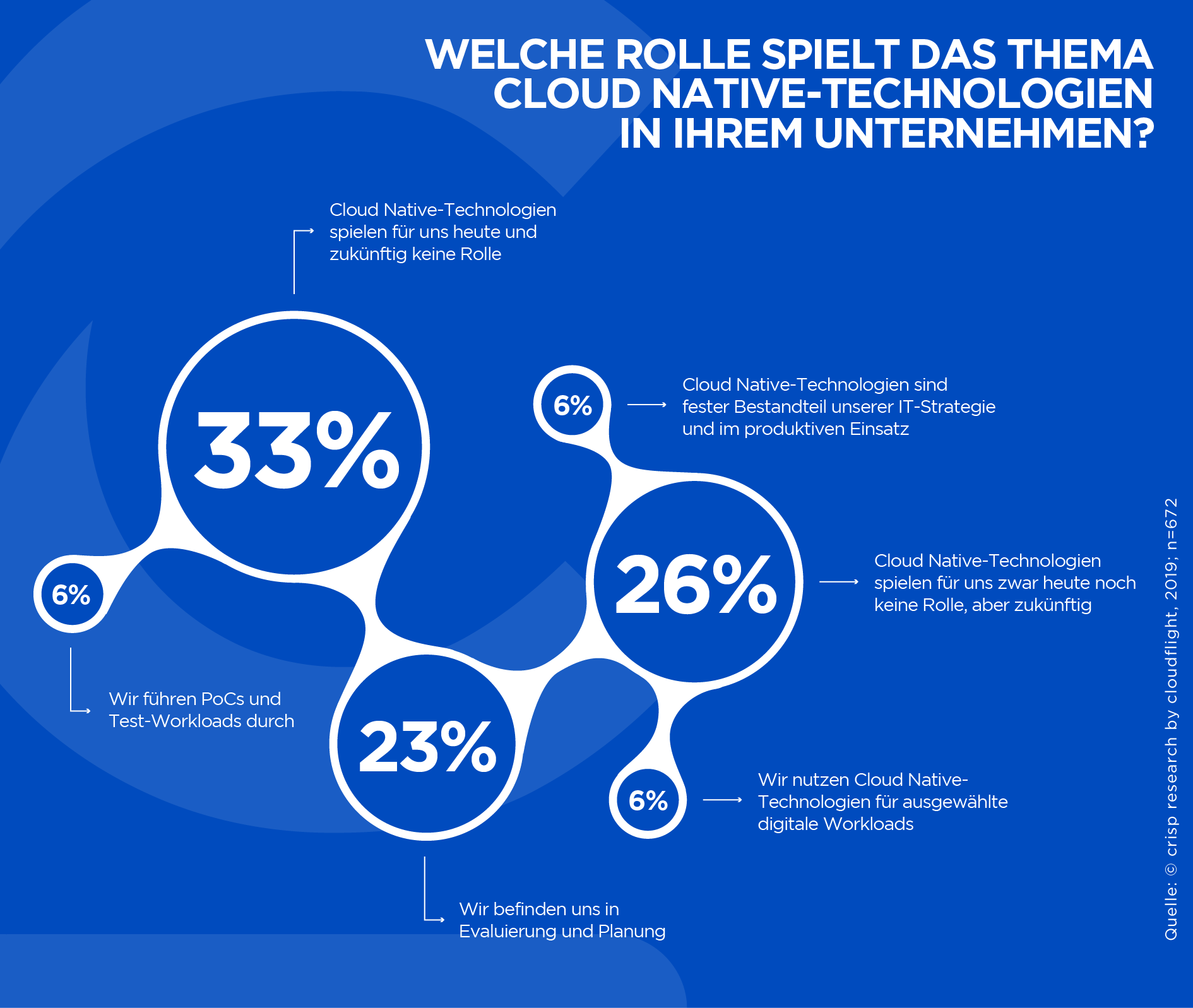

Im Frühjahr werden Cloudflight und sein Research Brand Crisp Research die erste Studie zum Status von Cloud Native in Deutschland veröffentlichen. Exklusive Ergebnisse bestätigen, dass zwei Drittel der Unternehmen nicht nur Kubernetes, sondern auch weitere Technologien aus der Cloud-Native-Landschaft, insbesondere Open-Source-Lösungen zum Betrieb von Cloud- und Non-Cloud-Infrastrukturen nach neuestem Standard, fest einplanen. 2020 wird das Jahr für Cloud Native – allen Widrigkeiten zum Trotz!

Cloud Native & Kubernetes Trends 2020

- Kubernetes Prod 2.0: Die Erfahrungen mit Kubernetes im produktiven Betrieb waren bei vielen Unternehmen im vergangenen Jahr sehr positiv. Der Aufbau und Betrieb, insbesondere agiler Umgebungen und Anwendungskonzepte mit Kubernetes und Cloud Native Tools, haben die gewünschten Erfolge in Sachen Agilität, Flexibilität, Performance und Kosten gebracht. Nun zünden viele Unternehmen schon die nächste Stufe im Kubernetes-Betrieb, optimieren ihre Cluster und trimmen die Workloads auf ein möglichst effizientes Niveau. Die Skalierung der Workloads innerhalb eines Kubernetes-Clusters um geänderten Anforderung (mehr Last / weniger Last) gerecht zu werden wird wichtig sein, um auch in besonders kostensensitiven Bereichen einen agilen und innovativen Plattformbetrieb sicherzustellen oder Services mit der gewohnten Performance bereitzustellen.

- Kubernetes-nativer Software Boom: In den Anfangsphasen von Kubernetes existierte die Software, die innerhalb der Container betrieben werden sollte zumeist schon – zumindest ihre Funktionsweise und Architektur waren festgelegt. Um die Vorteile von Kubernetes komplett auszunutzen und moderne Betriebsmodelle besser zu unterstützen, sind aber Anpassungen nötig. Kubernetes hat sich gewissermaßen als Betriebs- und Virtualisierungslayer in den Fokus gerückt. Im jetzigen Stadium hat Kubernetes bereits den Stellenwert erreicht, dass die Unternehmen und Entwickler direkt auf Kubernetes- und Container-Clustern ihre Anwendungen entwickeln und speziell darauf abstimmen. Somit wird Kubernetes Native Software in den kommenden Monaten immer mehr von Bedeutung sein und das Design moderner Anwendungen mit definieren.

- Kubernetes on the Edge: Schon längst ist Kubernetes nicht mehr alleine für die großen Public-Cloud-Infrastrukturen gemacht. Schon lange Zeit experimentieren die Anwender mit dem Einsatz von Kubernetes in On-Premise-Umgebungen mit teilweise spezifischen Stacks und Anforderungen an den Betrieb. Mit dem Hype und der steigenden Bedeutung des Edge Computings, insbesondere für Embedded Systems und IoT-Architekturen, entwickelt sich auch Kubernetes in Richtung der Edge. Mit KubeEdge läuft derzeit ein spannendes Projekt, um die Management- und Deployment-Fähigkeiten von Kubernetes und Docker auch in diesem Umfeld erfolgreich einsetzen zu können und paketierte Anwendungen auf den Geräten bzw. an der Edge betreiben zu können.

- Kubernetes goes Machine Learning: Neben IoT und Edge Computing steht auch Machine Learning als Megatrend auf der Agenda der Entscheider und der Cloud Native Community. Datenbasierte Geschäftsmodelle beginnen langsam erste Früchte zu tragen und Unternehmen identifizieren immer erfolgreicher Use Cases, um Datenbestände aus der eigenen Wertschöpfungskette und dem Ökosystem sinnvoll zu verwenden und zu monetarisieren. Das passende Projekt dazu ist Kubeflow. Die Entwickler dahinter verfolgen das Ziel Deployments von Machine Learning Workflows in Kubernetes zu optimieren. So soll die Portabilität und Skalierbarkeit von Machine-Learning-Plattformen erhöht werden.

- Cloud Native im RZ: Kubernetes und Cloud-Native-Technologien sind zwar per se für den Einsatz in und für die Public Cloud entwickelt. Allerdings wurden schon frühzeitig auch innerhalb von On-Premise-Architekturen die Lösungen für die Verwaltung von Anwendungs- und Container-Clustern und das Infrastrukturmanagement genutzt. In der großen M&A-Welle schnappte sich Virtualisierungsspezialist VMware das Container-Start-up Heptio. Einige Monate später kommt nun für die vSphere-Suite in der Version 7 eine komplette restrukturierte Plattform auf Kubernetes-Basis für die Kunden in die allgemeine Verfügbarkeit. Damit ist der Grundstein für die Bedeutung von Kubernetes auch außerhalb der Cloud und in den Rechenzentren gelegt und wird sich rasch in den Unternehmen ausbreiten.

- Kubernetes als neuer Hafen für Packaged Software: Viele Unternehmen und Softwareanbieter haben mit Kubernetes eine Möglichkeit entdeckt, bestehende Standard-Software auf Container-Basis zu betreiben. Durch die Dekomposition der Anwendung können so neue Nutzungsmöglichkeiten geschaffen werden. Auch ISVs bieten mittlerweile viele ihrer Standardlösungen direkt auf Container und Kubernetes an. Dazu zählen auch bestehende Middleware-Produkte, wie es beispielsweise die Software AG auf Amazon Web Services macht. Dieser Trend wird sich in diesem Jahr noch verstärken, sodass Kubernetes nicht nur für Custom Build Software, sondern auch für Packaged Apps und Middleware ein Faktor wird.

- Der heimliche Sieger OpenShift: On-Premise und Multi-Cloud-Umgebungen rund um Kubernetes hat auch Red Hat frühzeitig in den Fokus seiner Produktentwicklung genommen. Mit OpenShift ist eine Kubernetes-Distribution auf dem Markt, die als Platform-as-a-Service noch mehr Dienste bereitstellen kann, als das eigentliche Kubernetes-Framework. Die Entwickler haben darauf geachtet, die Vorteile von Open-Source-Lösungen, die Kombination der führenden Tools aus der Cloud-Native-Welt und die Erfahrung der Red Hat Historie zu kombinieren und so für jede Infrastrukturumgebung, sprich eine beliebige Public Cloud, Private Cloud oder On-Premise-Umgebung, sowie eine Kombination daraus die OpenShift-Plattform verfügbar zu machen. Daher setzen immer mehr Unternehmen und Entwickler erfolgreich auf OpenShift, um containerisierte Anwendungen zu entwickeln, zu betreiben und weiterzuentwickeln.

- Hire or Buy or Automate: Noch immer sind die Fähigkeiten, die es braucht, um Cloud-Native-Umgebungen zu beherrschen und Kubernetes zu betreiben, extrem rar gesät. Spätestens wenn die Landschaft der Cloud-Native-Technologien eine kritische Bedeutung für die Digital- und Software-Strategien eingenommen haben, müssen die Unternehmen auch im Stande sein, diese fortlaufend zu pflegen. Die wenigsten Unternehmen können dieses Skill-Set schon ihr Eigen nennen oder in kurzer Zeit aufbauen. Daher bleiben für sie nur die Möglichkeiten, neue Mitarbeiter mit diesen Fähigkeiten einzustellen, sich Hilfe von Dienstleistern zu nehmen, die diesen Bereich federführend verantworten oder gemeinsam mit der eigenen IT, den Dienstleistern und den zur Verfügung stehenden Tools eine automatisierte Umgebung zu errichten, welche die notwendigen Aufgaben maßgeblich übernehmen kann. Alle Optionen haben in Sachen Kosten, Qualität und Nachhaltigkeit ihre Vor- und Nachteile. Am Ende bleibt die Frage, mit welcher Intensität und Kritikalität die Cloud-Native-Technologien im Unternehmen Einzug erhalten sollen.

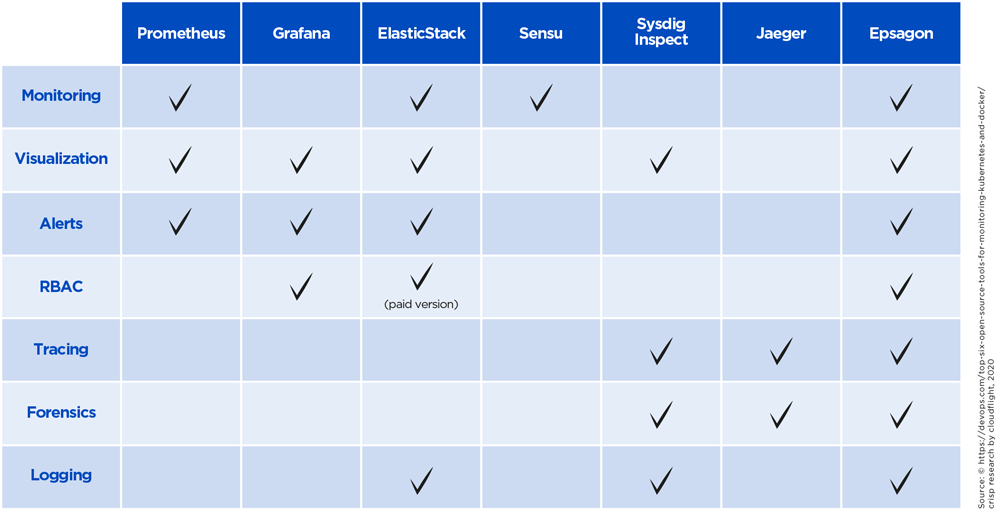

- Moving Beyond Kubernetes: Kubernetes ist und bleibt der Shootingstar der Cloud-Native-Welt, um den sich alle Projekte und Angebote ranken. Doch auch neben Kubernetes entwickelt sich eine Welt von Technologien, die immer mehr Bedeutung für die Praxis einnimmt und Kubernetes selbst zunehmend kommoditisiert. So werden Kubernetes und vor allem dessen Distributionen auch langfristig wichtig sein. Den Unterschied machen künftig aber vor allem die Tools drumherum aus. Denn wenn Kubernetes schon bald, wenn auch in unterschiedlichen Flavors, überall in den Unternehmen vorhanden ist, braucht es die richtigen Tools für die Entwicklung, Verwaltung, Überwachung und Optimierung der Infrastruktur. Egal ob Tracing, Service Mesh oder die Visualisierung der Plattformen – jeglicher Service kann den Unterschied ausmachen und die Go-to-Market-Zyklen der Anwendungen verbessern, Kosten im Betrieb senken oder die Performance der Plattform steigern. Daher wird auch die Wahl der Technologien des Kubernetes-Ökosystems immer mehr zum Erfolgsfaktor.

- Ende der Docker-Vorherrschaft: Wenn Kubernetes die Container-Orchestrierungs-Frameworks beherrscht, galt Docker gleichermaßen für die führende Container-Technologie selbst. Doch diese Vorherrschaft scheint nun endgültig in Frage gestellt zu werden. Denn einerseits bieten sich unmittelbare Alternativen, andererseits auch andere Wege, um Anwendungen in Containern zu betreiben und Pods (Container-Gruppen) zu verwalten. So werden Technologien wie containerd, CRI-O oder knative auf den Plan gerufen, die teilweise mit erheblich weniger Coding-Aufwand oder im Serverless-Betrieb funktionieren. Zusammen mit der etwas unklaren Zukunft durch die Übernahme Dockers durch Mirantis wird die Vielfalt der Container-Tools künftig vermutlich eher noch zunehmen, bevor sich eine neuerliche Konsolidierungswelle einstellt.

- Microservices mit Service Mesh: Microservices-Architekturen bestimmen langsam aber sicher die geschäftskritischen digitalen Anwendungen der Unternehmen. Bestehende Monolithen wurden teilweise umgebaut und neu entwickelt, neue digitale Plattformen werden ohnehin in kleinteilige Services aufgeteilt. Für die automatisierte Kommunikation untereinander und das Management haben sich Service Mesh Tools wie Linkerd oder Istio hervorgetan, teilweise sogar als graduated Project der Cloud Native Computing Foundation (CNCF) , was den hohen Reifegrad einer Technologie im CNCF Universum ausdrückt. Gerade diese Tools werden für die Unternehmen und deren digitale Plattformen besonders wichtig sein. Damit lohnt sich der Blick auf den Einsatz und die Funktionsweise der Service Mesh Tools.

- Tracing Boom: Neben Service Meshes wird auch (Distributed) Tracing für die Microservices-Architekturen immer wichtiger. In verteilten Systemen können Tools wie Jaeger (graduated innerhalb der CNCF Ende 2019) dabei helfen, Netzwerktransaktionen zu überwachen, Root-Cause-Analysen zu fahren oder die Netzwerk-Performance und Latenz zu optimieren. Das wird in den wachsenden Plattformarchitekturen mit immer mehr Abhängigkeiten unter den Microservices immer wichtiger. Das OpenTelemetry Project setzt auf Jaeger auf und kombiniert es mit weiteren Diensten wie Prometheus, um ein Set an APIs und Libraries für die Überwachung der Cloud-Native-Systeme anzubieten.

- Most Wanted: Standards: Die Flut an Projekten und Services, die derzeit im Cloud-Native-Umfeld angeboten werden, offenbaren gleichzeitig ein wachsendes Problem. Unternehmen und Entwickler müssen nicht nur ihre Microservices-Landschaften, sondern auch zahlreiche Management-Werkzeuge orchestrieren können. Unzählige verschiedene Projekte mit unterschiedlichen Einsatzzwecken sorgen dafür, dass nur wenige echte Standards existieren. Der Fokus auf führende Tools, die Zusammenfassung der Dienste und gemeinsame Standards werden zunehmend wichtig, um den Überblick zu behalten und auch langfristig das Wachstum der Architektur sicherzustellen. Hier sind die CNCF, die Vertreter führender Projekte, aber auch die Anwender gefragt, sich auf diese Standards zu verständigen.

- Proprietäre Services vs. Open Source Stacks: Cloud Native und Open-Source-Technologien sind bereits zum integralen Bestandteil der großen Cloud Provider geworden. Allerdings sind diese immer noch (zurecht) daran interessiert, ihre eigenen Dienste weiterzuentwickeln und zu vermarkten. Ob Analytics Services, Datenbankdienste oder die Management Tools auf den Cloud-Plattformen oder Tools und Frameworks für das Hybrid Cloud und RZ-Management – alle haben einen spezifischen Einsatzzweck und sind speziell auf den Anbieter-Stack abgestimmt. Derzeit sind viele der Tools, bspw. eine DynamoDB oder Simple Queue Service (SQS) von AWS, noch führend bzw. Open-Source Alternativen deutlich überlegen. Dennoch können sich die Anwender künftig berechtigterweise die Frage stellen, ob ein Open Source Stack ihre Anforderungen gleichwertig erfüllen kann und somit mehr Flexibilität versprechen. Dies wird eine Kernfrage sein, die bei der Architekturevaluation 2020 gestellt werden wird.

- Kubernetes Provider – ready to rule them all: Wenn Unternehmen neue digitale Plattformen auf Basis von Cloud-Native-Technologien und -Architekturen entwickeln möchten, kommen sie nahezu nicht mehr an einem Provider vorbei, der sich genau darauf spezialisiert hat. Planung, Aufbau, Entwicklung und Betrieb der containerisierten Anwendungen und die Integration mit dem gesamten IT-System werden nur funktionieren, wenn sich die handelnden Personen mit den Technologien auskennen, die Ziele vor Augen haben und diese auch zu erfüllen wissen. Daher werden diese Dienstleister in diesem Jahr besonders gefragt sein, um Effizienzsteigerungen der Bestandssysteme oder die Realisation neuer digitaler Plattformen überhaupt gewährleisten zu können. Solche Projekte autodidaktisch und in Eigenregie zu übernehmen, könnte für die Unternehmen fahrlässig und kostspielig enden.

Corona vs. Cloud Native

Ungewissheit und Krisenmanagement plagen die Unternehmen. Von neuen Innovationsprojekten wird im ersten Impuls vorerst Abstand genommen. Unternehmen müssen zunächst ihre Notfallpläne in den Griff bekommen. Dort wird es notwendig sein, eine besonders stabile und ausfallsichere IT bereitzustellen. Hier können Cloud Native Tools jedoch helfen, die Überwachung und Performance der Systeme sicherzustellen. Dazu ist Geschwindigkeit gefragt. Außerdem geht es in Corona-Zeiten für viele Unternehmen um Elastizität. Manche Unternehmen fahren ihre Tätigkeiten fast vollständig herunter, andere, wie insbesondere im Medizinsektor, multiplizieren ihre Anstrengungen und damit auch den Bedarf an IT-Infrastruktur. Hier können Container- und Cloud-Native-Technologien schon jetzt die betriebswirtschaftlichen Überlebensstrategien beflügeln.

Darüber hinaus wird es auch eine Zeit nach “Corona” geben, in der digitale Business-Konzepte und Plattformen wieder oder ganz besonders wichtig sein werden, um das Wachstum der Unternehmen auch nach schwierigen Zeiten zu sichern. Selbst wenn Corona ein stetiger Begleiter unserer Welt bleiben wird, zeigen die aktuellen Beispiele mitunter deutlich, wo die Hausaufgaben in Sachen Digitalisierung bei den Unternehmen sind – ob in Richtung Partner, Mitarbeiter oder Kunde. Wer jedoch schon die Übergangszeit nutzen kann, um hier die Weichen zu stellen, kann als Sieger hervorgehen.

Lesen Sie weitere Empfehlungen für Entscheider, sowie zusätzliche Hintergrundinformationen aus der Welt von Kubernetes und der Cloud Native Computing Foundation in unserem Report, den Sie kostenlos herunterladen können.